DeepSeek本地化部署指南

2025年2月14日

DeepSeek自托管部署指南(家庭实验室版)

通过本指南,您可在家庭实验室或家庭办公服务器上私有化部署DeepSeek模型,在受控环境中充分发挥AI潜力。DeepSeek本地化部署指南以及模型参数大小和硬件配置要求 deepseek本地部署使用 deepseek本地电脑部署 deepseek本地部署电脑配置 deepseek本地一键部署 deepseek 部署在本地 deepseek本地模型部署

为何选择自托管DeepSeek

注意:DeepSeek-R1是包含671B参数的混合专家模型(MoE),需1.5TB显存,消费级硬件无法运行。但其蒸馏模型(如DeepSeek-R1-Distill-Qwen-7B/LLaMA-70B)基于开源模型微调,继承了DeepSeek的推理能力且部署成本更低。

优势:

- 隐私性:数据完全本地存储,不经过第三方服务器

- 速度:低网络延迟(尤其小模型)

- 硬件定制:自由配置CPU/GPU/内存资源

- 扩展性:可随时升级家庭实验室硬件

- 控制权:无外部依赖或供应商锁定

- 学习价值:通过管理自有AI基础设施提升技能

挑战:

- 模型限制:部分敏感话题存在回答限制(可使用open-r1无审查版)

- 成本:硬件购置与持续电费支出

- 维护:需定期更新和技术维护

- 扩展瓶颈:物理空间、噪音与散热限制

部署准备

硬件需求:

- CPU:12核以上多核处理器(推荐Intel i7/i9或AMD Ryzen 9)

- GPU:支持CUDA的NVIDIA显卡(推荐RTX 4080/4090/A100)或AMD显卡(需ROCm)

- 内存:至少16GB,建议32GB+(大模型需求)

- 存储:NVMe SSD(推荐1TB+)

- 系统:Ubuntu或兼容发行版(推荐22.04 LTS)

其他准备:

- 确认网络环境:建议有线局域网连接

- 关闭非必要服务以释放资源

- 安装最新驱动和系统更新

安装步骤

- 基础环境配置

bash复制

# 安装Ollama框架 curl -fsSL https://ollama.com/install.sh | sh # 运行DeepSeek蒸馏模型(以8B版本为例) ollama run deepseek-r1:8b

- 安装Open WebUI界面

bash复制

# 通过pip安装(推荐) pip install open-webui # 或通过Snap安装 sudo apt update && sudo apt install snapd sudo snap install open-webui --beta # 启动Web服务 open-webui serve

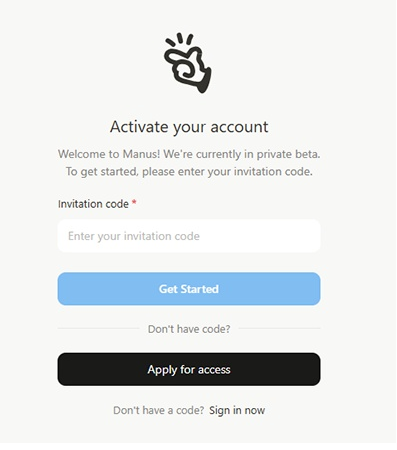

- 访问地址:http://localhost:8080 或替换为服务器局域网IP

网络访问配置

方案一:SSH隧道(推荐)

- 配置SSH服务端

bash复制

sudo apt install openssh-server sudo systemctl enable --now ssh

- 防火墙规则

bash复制

sudo ufw allow from 192.168.1.0/24 to any port 22,8080 proto tcp

- 建立隧道连接

bash复制

# 本地执行(将8080映射到服务器8080端口) ssh -L 8080:localhost:8080 user@服务器IP

- 浏览器访问:http://localhost:8080

优势:加密通信、无需开放额外端口

优化:使用autossh实现持久连接:

sudo apt install autossh autossh -M 0 -f -N -L 8080:localhost:8080 user@服务器IP

方案二:Nginx反向代理

- 安装配置Nginx

bash复制

sudo apt install nginx sudo nano /etc/nginx/sites-available/deepseek

- 配置示例

nginx复制

server { listen 80; server_name deepseek.local; location / { proxy_pass http://localhost:8080; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; } } - 启用配置

bash复制

sudo ln -s /etc/nginx/sites-available/deepseek /etc/nginx/sites-enabled/ sudo nginx -t && sudo systemctl restart nginx

优化与维护

- 硬件监控

bash复制

# GPU使用情况 watch -n 5 nvidia-smi # 内存/CPU监控 htop

- 服务自启动

创建Systemd服务文件/etc/systemd/system/deepseek.service:ini复制[Unit] Description=DeepSeek AI Service After=network.target [Service] ExecStart=/usr/local/bin/ollama run deepseek-r1:8b Restart=always User=aiuser [Install] WantedBy=multi-user.target

- 定期更新

bash复制

# 更新模型版本 ollama pull deepseek-r1:latest

注意事项

- 安全建议:

- 避免将服务暴露到公网

- 使用非root用户运行服务

- 定期备份~/.ollama目录中的模型数据

- 性能调优:

- 启用GPU加速:export CUDA_VISIBLE_DEVICES=0

- 使用量化模型减少显存占用

- 调整OLLAMA_NUM_PARALLEL控制并发请求数

- 故障排查:

bash复制

# 查看服务日志 journalctl -u ollama -f # 重置环境 ollama rm deepseek-r1:8b && ollama run deepseek-r1:8b

通过本方案,您可在家庭网络中构建私有化AI服务平台,享受低延迟、高安全性的智能服务。建议从较小模型开始验证,逐步扩展硬件配置。

在本地化部署中运行 DeepSeek 可提高控制力、隐私性和性能。自托管 DeepSeek 还可消除对外部云依赖的依赖,提高安全性并提供更多自定义选项。非常适合家庭实验室爱好者、开发人员和专业人士。

* DeepSeek-R1 是一个 671B 模型,具有混合专家 (MoE) 架构,可实现任务专业化。它需要大约 1.5 TB 的 VRAM,因此安装它远远超出了消费级硬件的自托管能力。它是在多样化的数据集上从头开始训练的,以实现强大的推理和语言理解能力。DeepSeek-R1-Distill 模型是 LLaMA 和 Qwen 等开源模型的微调版本,这些模型是在 DeepSeek-R1 生成的数据上进行训练的。这些精简模型(如 DeepSeek-R1-Distill-Qwen-7B 和 DeepSeek-R1-Distill-LLaMA-70B)继承了各自模型的基础模型,但获得了 DeepSeek 微调引入的推理能力。与需要大量计算资源的完整 DeepSeek-R1 模型相比,它们在消费级硬件上的部署效率更高、更实用。尽情享受吧!

以下是针对 8 位量化 DeepSeek R1 的硬件建议的粗略指南。请记住,这些是粗略数字,会根据您的设置而有所不同。较大的模型(尤其是 70B 和 671B)通常在多 GPU 或分布式设置中运行,因此在这些情况下,这些数字是针对“每个节点”或“每个 GPU”的基准。

8 位量化 DeepSeek R1 的硬件要求

| Model | System RAM | CPU Cores | GPU VRAM | Recommended Nvidia GPU | Recommended AMD GPU |

|---|---|---|---|---|---|

| 1.5B | 16 GB | 4 | 8 GB | RTX 4060 Ti 8GB | RX 7600 8GB |

| 7B | 32 GB | 8 | 16 GB | RTX 4060 Ti 16GB | RX 7700 XT 12GB |

| 8B | 32 GB | 16 | 16 GB | RTX 4060 Ti 16GB | RX 7800 XT 16GB |

| 14B | 64 GB | 24 | 16–24 GB | RTX 4090 24GB | RX 7900 XT 24GB |

| 32B | 128 GB | 32 | 32–48 GB | RTX A6000 48GB | Instinct MI250X |

| 70B | 256 GB | 48 | 48+ GB | A100 80GB | Instinct MI250X |

| 671B | 1 TB+ | 64+ | 80+ GB | H100 80GB (multi‑GPU) | Instinct MI300 (multi‑GPU) |

注意:

– 16GB GPU 可以进行积极优化,但更多的 VRAM(或多 GPU)可以提供更多的空间。

– 对于生产用途(尤其是较大的模型),您可能需要进一步调整配置或使用多 GPU 策略来处理峰值内存和吞吐量要求。

4 位量化 DeepSeek R1 的硬件要求

| Model | System RAM | CPU Cores | GPU VRAM | Recommended Nvidia GPU | Recommended AMD GPU |

|---|---|---|---|---|---|

| 1.5B | 16 GB | 4 | 8 GB | RTX 3050 (8 GB) | RX 6600 (8 GB) |

| 7B | 16 GB | 6 | 8 GB | RTX 3060 (8 GB) | RX 6600 XT (8 GB) |

| 8B | 16–32 GB | 8 | 8–12 GB | RTX 3060 (12 GB) | RX 6700 XT (12 GB) |

| 14B | 32 GB | 12 | 12–16 GB | RTX 4060 Ti (16 GB) | RX 7800 XT (16 GB) |

| 32B | 64 GB | 16 | 16–24 GB | RTX 4090 (24 GB) | RX 7900 XTX (24 GB) |

| 70B | 128 GB | 16–24 | 24–32 GB | A100 40 GB (or H100) | Instinct MI250X |

| 671B | 512 GB+ | 32+ | 40+ GB | A100/H100 (multi‑GPU) | Instinct MI300 (multi‑GPU) |

注意:

– 对于较小的模型(1.5B、7B、8B),4 位量化可以在具有 8-12 GB VRAM 的中档 GPU 上运行。

– 对于 14B,像 RTX 4060 Ti(或 RTX 4070)这样的中档 GPU 在 4 位模式下就足够了。

– 即使使用 4 位量化,较大的模型(32B 及以上)仍然是重量级的。例如,32B 模型可能适合 24 GB GPU(如 RTX 4090),并具有优化和卸载功能,而 70B 和 671B 通常需要企业级数据中心 GPU 和多 GPU/分布式配置。